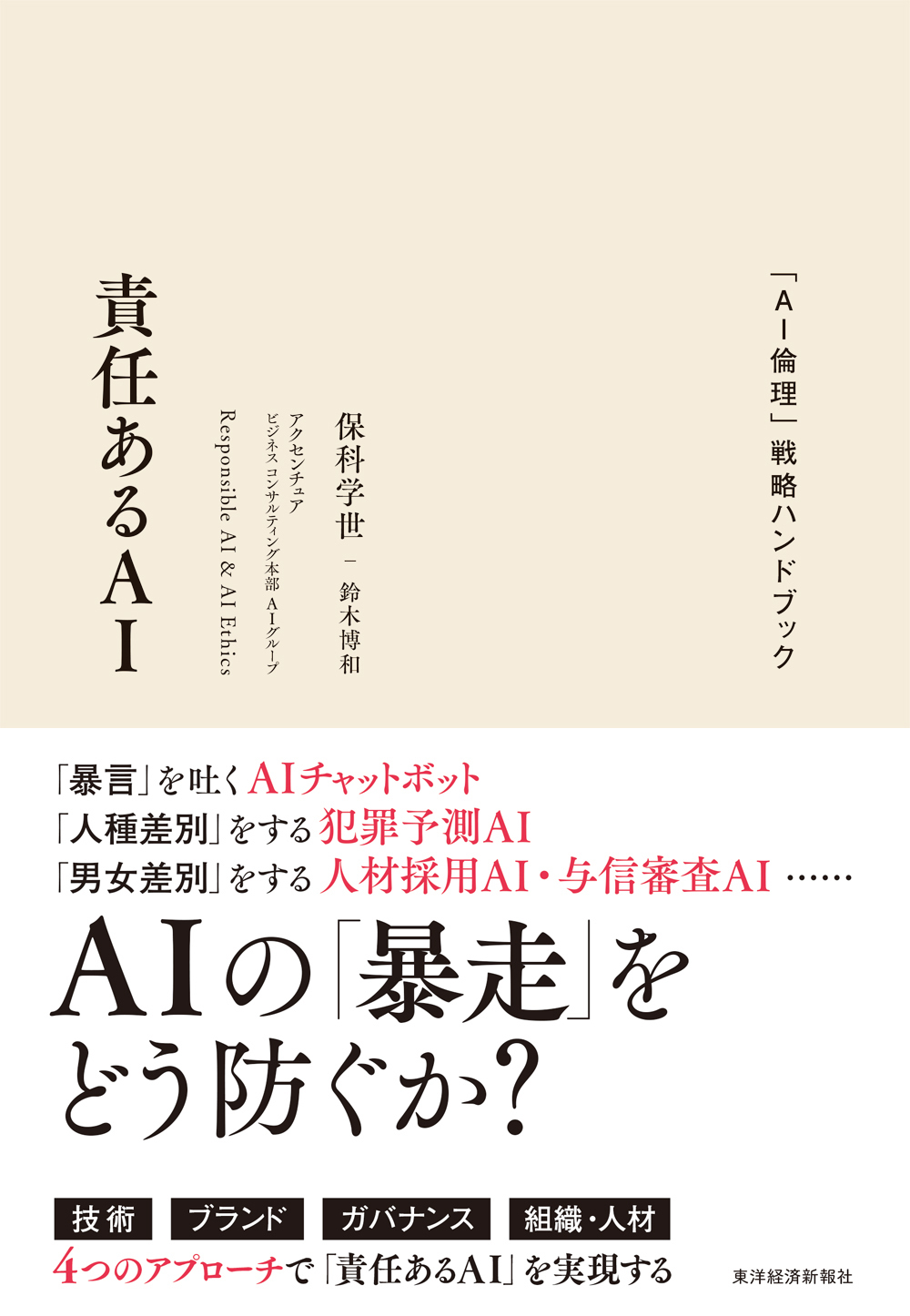

責任あるAI

「AI倫理」戦略ハンドブック

「暴言」を吐くAIチャットボット

「人種差別」をする犯罪予測AI

「男女差別」をする人材採用AI・与信審査AI……

AIの「暴走」をどう防ぐか?

「技術」「ブランド」「ガバナンス」「組織・人材」

4つのアプローチで「責任あるAI」を実現する

「責任あるAI」のベースにあるのは

「人間中心」のデザインであり、人間が意思決定の中心となることである。

「責任あるAI」実現のために守るべき規範が「AI倫理」である。

【主要目次】

Part1「責任あるAI」「AI倫理」とは何か?

●なぜ今「責任あるAI」が重要なのか?

・デジタルツインの波とAI

・労働生産性におけるAIの貢献

・意思決定におけるAIの役割

・加速するAIへの法規制

●求められる「AI倫理」とは?

・アシモフの「ロボット工学原則」と抜け穴

・AIのガイダンス制定の世界的な流れ

・「責任あるAI」と5つの行動原則「TRUST」

●AIの潜在的リスクに備える4つの観点からのアプローチ

・AIに混入する潜在的リスクとは?

・各産業分野におけるAI適用と考えうるリスク

・AIの導入・定着のために求められる施策とは?

Part2「責任あるAI」を実践する4つのアプローチ

●技術のリスクを防ぐアセスメントの方法

・AIの開発プロセスで忍び寄るリスク

・リスクを表面化させるアルゴリズム・アセスメント(AA)とは?

●ブランド価値を守り、高めるESGアプローチ

・ESGによるブランド価値の創出・向上

・AI開発においても無縁ではない「環境」意識

●ガバナンスにおける効果的な「火消し」の方法

・AIガバナンスのロードマップ

・日本企業で導入が広がるAIガバナンス

●組織・人材に「AI倫理」を根付かせる

・研修プログラムとコミュニケーション

・具体的事例を用いた演習

・リーダー企業になるためのチェックリスト

概要

目次

●なぜ今「責任あるAI」が重要なのか?

・デジタルツインの波とAI

・労働生産性におけるAIの貢献

・意思決定におけるAIの役割

・ますます「人間の介在するAI」が重要になっていく

・頻発するAIのトラブルと「Black Lives Matter」

・加速するAIへの法規制

●求められる「AI倫理」とは?

・アシモフの「ロボット工学原則」と抜け穴

・AIのガイダンス制定の世界的な流れ

・「責任あるAI」と5つの行動原則「TRUST」

●AIの潜在的リスクに備える4つの観点からのアプローチ

・AIに混入する潜在的リスクとは?

・各産業分野におけるAI適用と考えうるリスク

・AIの導入・定着のために求められる施策とは?

Part2「責任あるAI」を実践する4つのアプローチ

●技術のリスクを防ぐアセスメントの方法

・AIの開発プロセスで忍び寄るリスク

・リスクを表面化させるアルゴリズム・アセスメント(AA)とは?

・統合的なアルゴリズム・アセスメントの必要性

●ブランド価値を守り、高めるESGアプローチ

・ESGによるブランド価値の創出・向上

・AI開発においても無縁ではない「環境」意識

・AIにおけるフェアトレード(倫理的調達)とは?

●ガバナンスにおける効果的な「火消し」の方法

・AIガバナンスのロードマップ

・日本企業で導入が広がるAIガバナンス

●組織・人材に「AI倫理」を根付かせる

・研修プログラムとこみゅにけー書

・具体的事例を用いた演習

・リーダー企業になるためのチェックリスト

・「責任あるAIの実現」に向けての心構え

著者プロフィール

ほしな がくせ

慶應義塾大学大学院理工学研究科博士課程修了。博士(理学)。アクセンチュアにてAI・アナリティクス部門の日本統括、デジタル変革の知見や技術を結集した拠点「アクセンチュア・イノベーション・ハブ東京」の共同統括を務める。AI HUBプラットフォームや業務領域ごとに体系化したAI サービス群「AI POWEREDサービス」、需要予測・在庫補充最適化サービスなどの開発、アナリティクスやAI技術を活用した業務改革を数多く実現。『アクセンチュアのプロが教える AI時代の実践データアナリティクス』(共編著、日本経済新聞出版)、『日経ムック AIフロンティア』(監修、日本経済新聞出版社)、『HUMAN+MACHINE 人間+マシン』(監修、東洋経済新報社)、『データサイエンス超入門――ビジネスで役立つ「統計学」の本当の活かし方』(共著、日経B社)など著書・監修書多数。厚生労働省保健医療分野AI開発加速コンソーシアム構成員などを歴任。一般社団法人サーキュラーエコノミー推進機構理事。

鈴木 博和 【著】

すずき ひろかず

東京工業大学大学院情報理工学研究科計算工学修士課程、東京理科大学大学院イノベーション研究科技術経営修士課程修了。事業会社にて十数年におよびAIの研究開発・マネジメントおよびエネルギー・デバイス・メディカルなど多領域での研究企画に従事。その後、IT系コンサルティング会社にて主に情報通信・流通・メディカル業界のクライアントに対し、自然言語処理を中心としたソリューションのPoC~導入・運用支援を多数経験。現在はアクセンチュアにて、AI POWEREDサービスの一つ、AI POWEREDバックオフィスの開発・提案・デリバリーのリードを行いながら、さまざまなAI技術を活用した業務改革の実現に日々奔走している。